Data Mining et Machine Learning

John Samuel

CPE Lyon

Year: 2023-2024

Email: john(dot)samuel(at)cpe(dot)fr

.jpg)

.png)

Soit

Alors

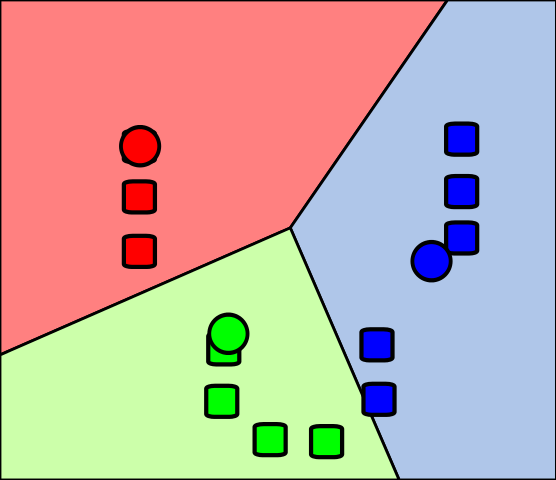

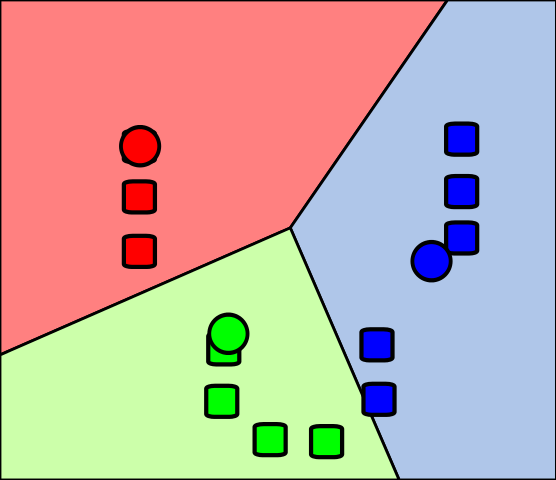

Prendre des décisions signifie appliquer tous les classificateurs à un échantillon invisible x et prédire l'étiquette k pour laquelle le classificateur correspondant rapporte le score de confiance le plus élevé : \[\hat{y} = \underset{k \in \{1 \ldots K\}}{\arg\!\max}\; f_k(x)\]

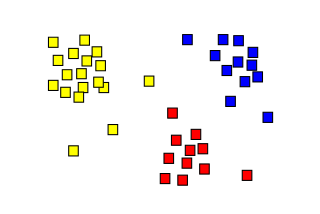

\[ C_1.. ∪ ..C_k ∪ C_{outliers} = X \] et

\[ C_i ∩ C_j = ϕ, i ≠ j; 1 <i,j <k \]

\(C_{outliers}\) peut consister en des cas extrêmes (anomalie de données)

\[ Y ≅ f(X,β) \]

| Balise | Signification |

|---|---|

| GPE | Pays, villes, états. |

| DATE | Dates ou périodes absolues ou relatives |

| CARDINAL | Les chiffres qui ne correspondent à aucun autre type. |

\[P(A|B) = \frac{(P(B|A).P(A))}{P(B)}\]

\[P(S|W) = \frac{P(W|S) \cdot P(S)}{P(W|S) \cdot P(S) + P(W|H) \cdot P(H)}\]